News

L’EU AI Act, quels risques, quels impacts, quels coûts pour les sociétés et leur dirigeants ?

L’UE est sur le point de promulguer une loi pour réguler les IA. Cette loi, parmi les premières au monde et sans doute la plus ambitieuse, a le potentiel de structurer durablement les organisations en contact avec les IA. C’est à dire toutes. Elle prévoit par ailleurs des pénalités colossales.[CP1]

Au-delà de la loi elle-même, nous assistons en direct à la naissance d’une discipline inexistante aujourd’hui : le management de la qualité d’une IA.

Nous allons aborder cette naissance en 3 étapes :

- Comprendre la loi, son esprit et les enjeux

- La mettre en relation avec les risques et difficultés inhérents aux IA

- Donner les clefs d’une mise en place du management de la qualité des IA, pour réduire ces risques et maîtriser les coûts

Deux définitions pour mieux cadrer :

Pour l’UE, l’intelligence artificielle, c’est :

un système automatique conçu pour opérer avec divers degré d’autonomie et qui génère des prédictions, recommandations ou décisions, pour des objectifs explicites ou implicites, ayant une influence sur son environnement physique ou virtuel

La qualité d’une IA

Pour une organisation, en posant la qualité d’une IA comme objet de test, d’inspection et de certification, alors : la qualité d’une IA se rapporte au degré auquel elle satisfait les prérequis tout au long de son cycle de vie. Ces prérequis sont exogènes : loi, standard obligatoire, cahier des charges du commanditaire, garanties légales, etc., et endogènes : objectifs du produit (détecter 99% des cancers…), objectifs et valeur de l’entreprise (zéro carbone…)

1- Le projet de Loi – EU AI Act

Lorsque l’UE a adopté la loi de protection des données GDPR, personne ne se sentait vraiment concerné. Jusqu’à la première amende élevée.

Le EU AI Act est une proposition de loi de l’Union Européenne. Elle définit un environnement pour encadrer les IA dans l’UE. Le projet de loi prévoit de s’appuyer sur des standards pour être mis en application de manière concrète. L’intérêt de conserver ces deux niveaux de définition (le couple Loi – Standards) est de maintenir une loi cadre qui s’adapte à la technologie au gré de l’évolution des standards qui définissent l’état de l’art. La loi elle-même résistera ainsi mieux aux assauts du temps court de la technologie. La version actuelle du projet semble assez proche de sa version définitive.

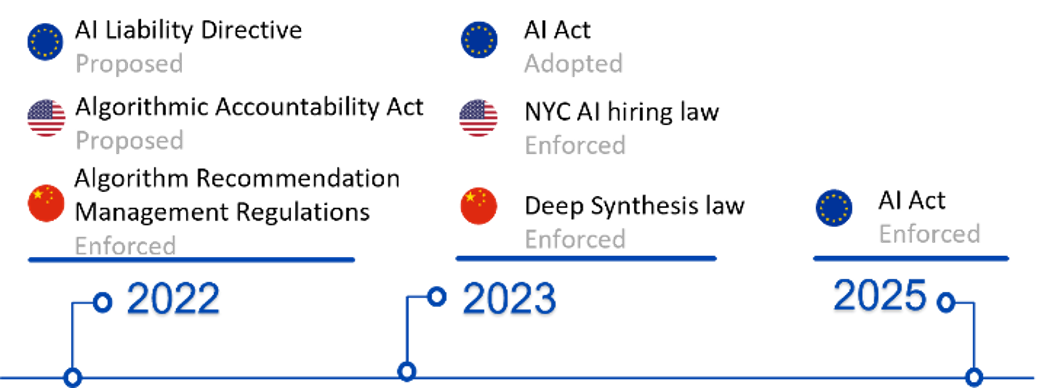

1.1 - EU AI Act dans le paysage mondial

Si la future loi Européenne n’est pas la seule à être dans la dernière ligne droite ou déjà promulguée, c’est de loin la plus aboutie et la plus englobante. Elle a par ailleurs des composantes s’apparentant à de l’extra-territorialité. Pour complexifier le tout, plus de 50 pays (source : HolonIQ, 2022) ont des initiatives de réglementation de l’IA, dessinant une jungle législative.

Un aperçu des 3 principaux acteurs en termes d’IA:

1.2 - Une réglementation horizontale

Les réglementations européennes peuvent être groupées en 2 catégories: verticales et horizontales. Les frontières entre ces groupes ne sont pas toujours bien claires, certaines lois horizontales ayant quelques éléments de verticalité et vice-versa. Le EU AI Act est une loi globalement horizontale.

- Un exemple horizontal est le RGPD (réglement général sur la protection des données): il touche tout le monde sans distinction d’activité. Que vous ayez une salle de concert ou que vous fabriquiez des pacemakers, vous êtes concerné.

- Un exemple vertical est le MDR (Medical Device Regulation) qui régit la mise sur le marché européen. La salle de concert n’est pas concernée, même lorsqu’elle installe un défibrillateur dans ses locaux.[CP1]

Cette future réglementation peut donc potentiellement impacter toutes les organisations (entreprises, associations, organismes publics), toutes activités confondues.

Par ailleurs, le loi concerne à la fois les IA faites en Europe (et potentiellement exportées) et les IA importées en UE.

1.3 – Mais suis-je vraiment concerné ?

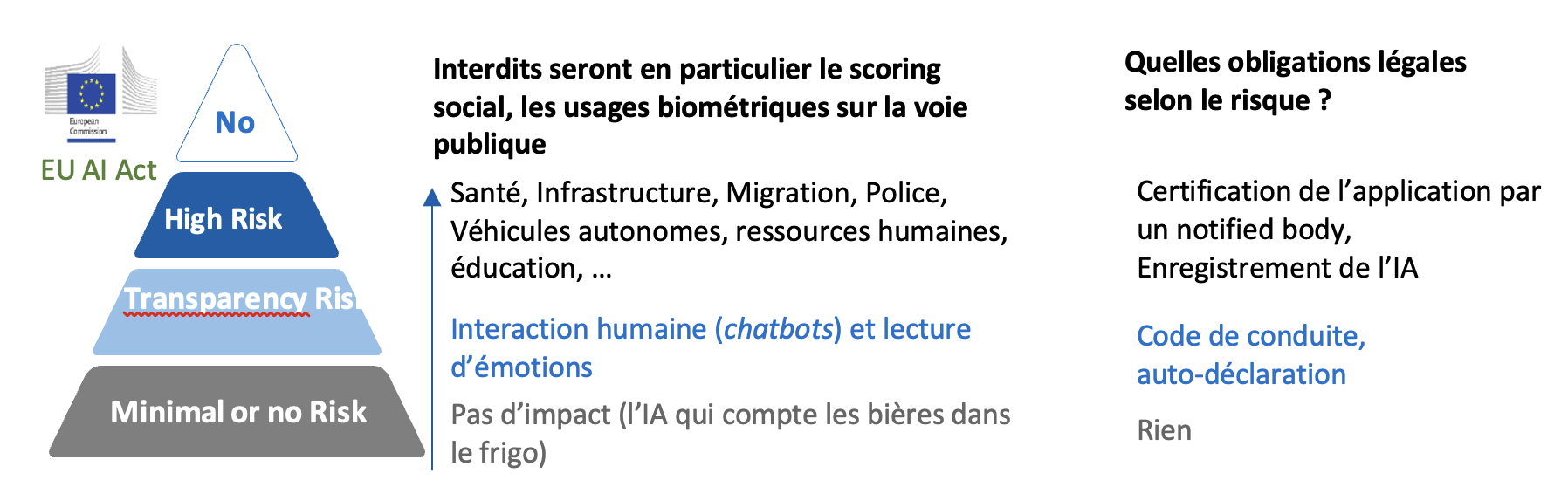

En réalité, la loi est basée sur la notion de risque. Plus le risque associé à l’IA est élevé, plus la réglementation est exigeante. Donc tout en bas de l’échelle, la loi ne prévoit pas ou peu de contraintes spécifiques. La notion de risque est liée à l’impact (éthique, santé, égalité des chances, démocratique...) sur l’individu et/ou la société.

Une certaine catégorie d’IA est encore mal adressée par cette catégorisation : les IA généralistes (e.g. chatGPT). Les annexes du projet de loi sont encore en cours de rédaction, et les lobbys sont très actifs pour les écarter de la loi.

Le risque est, de manière classique, adressé à l’ensemble de l’écosystème autour de l’IA. Ce qui est nouveau c’est :

- de nouveaux acteurs peu habitués à ces approches (SSII, Data farms…) ;

- une dimension supplémentaire dans des écosystème déjà très complexes (automobile…)

La notion de risque, centrale, mérite donc toute notre attention. Il y a deux classes de risques:

- le risque fonctionnel que fait peser l’IA sur l’individu ou la société ;

- le risque légal sur les sociétés et leurs dirigeants.

Afin de clore le chapitre sur le projet de loi, analysons tout d’abord ce dernier point.

1.4 - Pour une société, quelles pénalités sont prévues par la loi

Les pénalités encourues sont plus élevées que le RGPD, mais concernent principalement les applications à haut risque. En conséquence beaucoup moins d’organisations sont concernées : l’article 71 prévoit jusqu’à 6% du revenu mondial total et 30 M€ de pénalité. Auxquels il faut ajouter l’impact sur l’image de marque et les coûts de gestion d’un tel dossier, etc…

2- La gestion du risque d’une IA

La gestion du risque, le contrôle qualité… Rien de nouveau a priori. Quels sont alors les angles morts dans notre approche actuelle?

2.1 – La complexité intrinsèque des IA

Dans la gestion du risque usuelle, les systèmes sont explicables et déterministes. Dans la gestion du risque d’une IA, nous avons des boites noires, et le nombre de configurations possible de l’IA est hors de portée des ordinateurs : on ne peut simuler tous les états et donc garantir l’absence de risque.

Au-delà des risques évidents de certains systèmes (Voiture autonome, diagnostic médical…) largement médiatisés, il existe de nombreux autres risques plus techniques, parfois sous-jacents, mais tout aussi importants.

Citons quelques exemples célèbres sur l’éthique :

- L’IA de freinage d’une voiture doit-elle protéger ses passagers ou les piétons?

- Un algorithme d’assurance doit-il refuser une couverture à une nonagénaire?

2.2 – De nombreux risques tout au long du cycle de vie

La différence de gestion de risque entre l’IA eet un modèle déterministe se situe ailleurs. Pour l’illustrer, citons trois exemples parmi une vingtaine de risques possibles :

- Data governance : la gestion des data (en termes de supply chain, de nettoyage, de maintenance et d’accès)

- Biais algorithmique

- Concept drift : le modèle dérive au fur et a mesure de ses apprentissages.

Nous pouvons dégager différentes sources de risques :

- malveillance,

- compétence,

- process.

2.3 – Les risques face à la malveillance

Parmi les risques évoqués plus tôt, certains sont particulièrement sensibles à la malveillance.

Prenons l’exemple concret du data poisoning, qui consiste à infester en amont les data pour obtenir un résultat souhaité en aval dans un cas très spécifique. Il s’agit d’une attaque d’intégrité. Par exemple, vous vendez vos produits en ligne sur une plateforme. Votre concurrent paye un des employés de cette plateforme[DR1] pour faire modifier les datasets d’entraînement et faire remonter ses produits dans les algorithmes de recommandation plutôt que le vôtre. En pratique, quasiment indétectable.

Seul un contrôle amont permet de se prémunir. Ce type d’attaque est souvent dans la durée, dépendant de la fréquence à laquelle les modèles sont entraînes et déployés.

Le data poisining est possible dans une configuration blackbox se basant sur les retours des utilisateurs (massivement manipulés) ou en white box en manipulant l’intégrité du training data, parfois en amont dans une data farm.[CP2]

On peut encore citer:

- tromper volontairement un algorithme, par exemple par des images similaires (un fake-panneau sur la route),

- dé-anonymiser des data par le biais de requêtes ciblées,

- re-engineering.

Dans tous ces cas, seule une approche systématique et globale de l’IA, de ses data et de son environnement (employés, infrastructures…) permet la prévention.

2.3 – Les risques de l’incompétence

Selon le World Economic Forum, en 2022, 80% des projets IA en entreprise « fail to deliver ».

Pourquoi? Car les projets d’IA ne sont pas menés de manière structurée et qualitative comme le sont les autres projets. Souvent hors-sol et sans métriques clairs autres que la « performance » du modèle IA. Comme si on ne mesurait une nouvelle voiture qu’à la puissance du moteur.

L’incompétence – au sens où certaines compétences, les garde-fous ou l’attention manquent pour accomplir une tache - est plus répandue que la malveillance, et tout aussi nocive.

A la différence de produits classiques (analogues ou bien software classiques), le contrôle qualité spécifique IA n’existe pas. Dans un environnement de qualité habituel :

- les systèmes sont déterministes, et sont testés de manière exhaustive ;

- l’entreprise est protégée par des systèmes efficaces (contrôle qualité, cybersécurité, functional safety…).

Ces derniers sont malheureusement incomplets ou caducs face aux IA. Ils sont par ailleurs peu connus des équipes innovations / IA / data science. Ces derniers sont issus de formations universitaires et de parcours professionnels mettant plus l’accent sur les méthodes agiles, le « MVP » (minimal viable product) et la solution technologique que sur les contraintes d’un produit industriel dans sa globalité.

Exemple : Glissement des modèles sans boucle de contrôle.

Votre modèle apprend en permanence, recevant des nouvelles données en continu (feedback utilisateur, données environnementales…). Lorsque vous l’avez publié le mois dernier, vous avez bien validé ses inputs et outputs. Que s’est-il passé depuis ? A quelle fréquence se remettre en question ? Comment s’assurer que vous n’avez pas de nouveaux biais ? Quels mécanismes sont en places ?

Un exemple facile : le chatbot de Microsoft qui est devenu raciste en quelques heures…

Les questions types à se poser : qui a accès aux data ? Les changements sont-ils documentés ? Existe-t-il un plan de sauvegarde ? La gestion des versions, « le retour en arrière du modèle», est-il assuré ?

3- Comment faire face à ces nouveaux risques? Un plan d’action

Pour maîtriser ces risques, il y a plusieurs étapes:

- une prise de conscience (cet article par exemple) ;

- une analyse des risques spécifiques ;

- une intégration des IA dans le management de la qualité, accompagné d’un changement de culture des équipes ;

- une certification éventuelle.

Il ne s’agit pas d’une révolution, mais bien d’une évolution. De même que la cybersécurité a commencé avec des filtres spams et des antivirus dans les années 90, puis a évolué vers des problèmes d’infrastructure pour devenir une discipline globale et un marché dynamique, la qualité des IA va vraisemblablement prendre le même chemin, et de manière plus rapide, poussée par la pression de la loi.

3.1 – Premier pas : l’analyse de risque spécifique IA, préalable à toute initiative d’envergure

Pourquoi une analyse de risque ?

- Toutes les applications n’ont pas le même exposition au risque (EU AI Act).

- Tous les risques n’ont pas la même importance (scope x sévérité x fréquence).

Comment construire son analyse de risque ?

1. En interne: former un ou des experts sur les standards spécifiques IA et le EU AI Act et leur faire créer un modèle holistique d’identification des risques ;

2. en externe: faire appel à des partenaires. Attention ici à bien choisir : il ne s’agit pas d’appliquer un système propriétaire des big five ou autres, mais bien de se mesurer au cadre légal et aux standards…

3. Mixer les deux approches pour assurer l’acquisition de savoir-faire et l’indépendance à moyen terme.

Selon mon expérience personnelle, il y a environ une cinquantaine de risques IA pour une entreprise, que l’on peut grouper autour de :

- sûreté et sécurité,

- juridique,

- éthique & sustainability,

- performance.

Par exemple en sûreté : predictable, reliable, repeatable, robust, testable, traceable, accountable, explainable, locally stable… Bien entendu, il y a d’autres manières d’organiser l’information. Cette analyse de risque va permettre de prioriser les actions et de définir un chemin en interne vers la gestion active d’une IA dans son contexte légal et qualitatif.

3.2 – Vers le management de la qualité d’une IA

Nous avons vu que l’analyse de risque est la première étape. Ensiute, les méthodes habituelles s’appliquent pour conduire le changement :

- identifier les équipes clefs (IA, Qualité, Legal…)

- former (recruter ?) des équipes, à la fois techniques et management :

- les risques et les obligations,

- les méthodes et standards pour y répondre,

- intégrer les problématiques dans les fonctions d’achat ;

- intégrer les IA dans le système de management de la qualité ;

- construire un audit (interne ou externe), incluant les fournisseurs de data, les intégrateurs ;

- élargir les fonctions du compliance manager ;

- dans le cas des risques élevés, préparer son entreprise aux audits[DR1] et certifications à venir, en s’appuyant sur les pistes évoquées en amont.

3.3 – Par où commencer ?

Les bonnes adresses :

- vos organismes de certification habituels (SGS, TÜV, Dekra, Buro Veritas, …), dans la mesure ou ils couvrent les IAs ;

- vos partenaires de conseil, même si la plupart sont très en retard sur cet aspect spécifiques de l’IA. Ils sont historiquement plus impliqués sur les applications IA elle-mêmes, les infrastructures IA et la cybersécurité en général ;

- certaines associations professionnelles.

Conclusion

Un tsunami législatif et normatif est à l’horizon. La plupart des sociétés tournent encore le dos à la mer, fascinées par les perspectives qu’offrent les applications de l’IA. Une prise de conscience pour les organisations doit s’opérer face aux difficultés liées aux IA : compliance, scaling et usage responsable.

Cette vague va déferler sur deux ans, permettant l’intégration normative non seulement dans les systèmes d’innovation et de management des IA, mais aussi dans toute la chaîne d’approvisionnement.

Les contraintes sont techniques, multi-dimensionnelles et les enjeux sont à même d’impacter durablement la (sur-)vie d’une entreprise. Tout le monde ne sera pas impacté au même degré, mais tous auront bientôt les pieds dans l’eau. Il est encore temps d’apprendre à nager.

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.